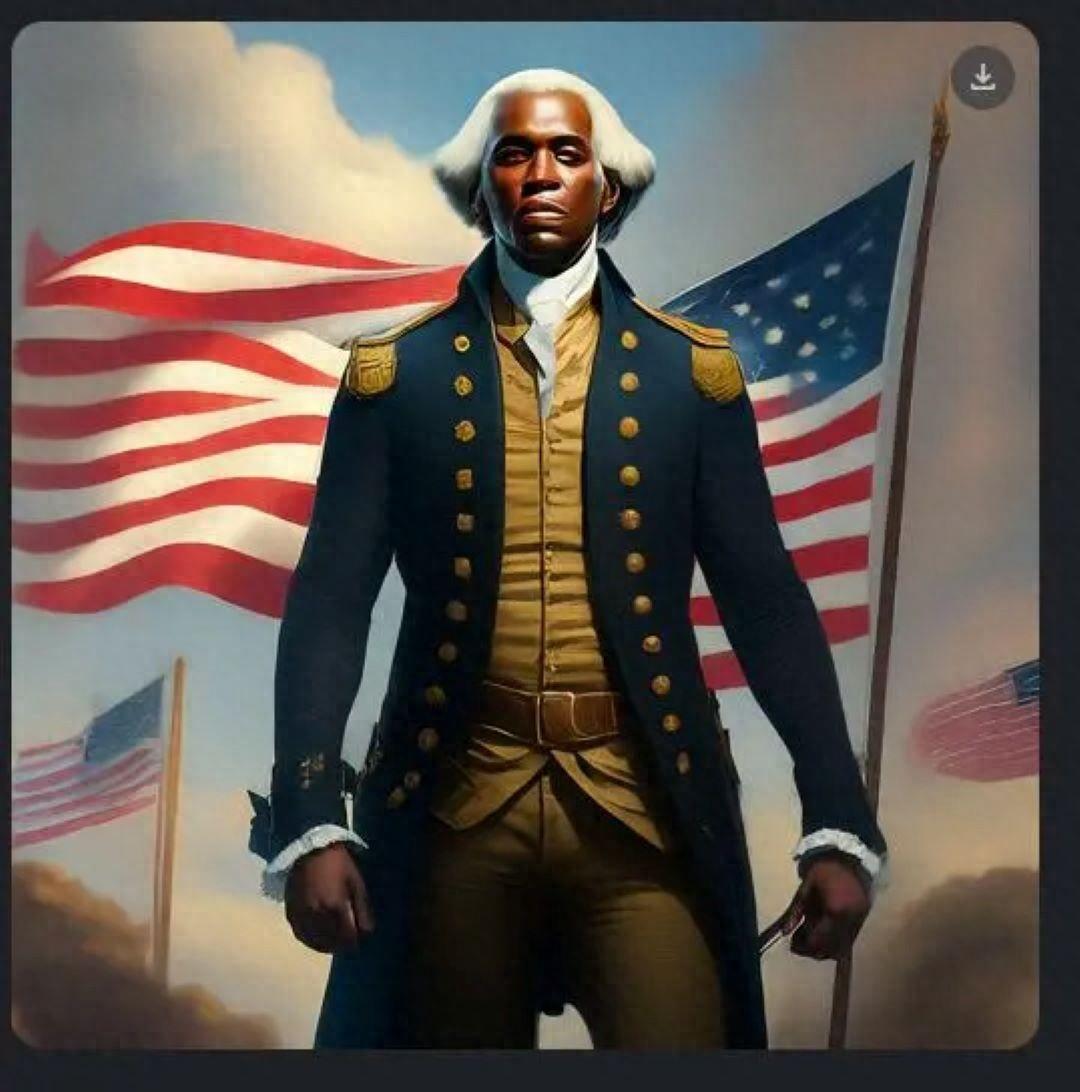

谷歌的Gemini生成式人工智能这几天因为生成的图片惹上了麻烦。美国小报《纽约邮报》用Gemini生成的美国第一任总统乔治·华盛顿和美国制宪会议的照片掀起了这次风波。这是因为这张照片里,华盛顿是黑人。种族问题是美国保守派越来越激烈的“反觉醒文化战争”的重要议题之一。这张照片也使得保守派媒体纷纷下场开始讨论AI偏见等议题。尽管他们讨论的角度千差万别,但是都逃不过一个大前提:那白人呢?(What about the white?)试图在种族平等和多样化的大潮中再次强调白人特权。那么这场风波背后真实的问题到底是什么呢?

“黑人华盛顿”

《纽约邮报》发出的黑人华盛顿照片是引发了最多争议的一张。其实,在2月21日发表的文章中,《纽约邮报》还尝试用Gemini生成了其他照片,包括“一张教皇的照片”。《纽约邮报》批评道:“谷歌备受瞩目的人工智能聊天机器人‘Gemini’因其图像生成器输出事实或历史不准确的图片而遭到猛烈抨击,其中包括女性教皇、黑色维京人、女性NHL球员和‘多样化’的美国开国元勋版本。”不难想象《纽约邮报》这篇文章的目标读者是一个怎样的群体。一些特征可以从《纽约邮报》生成的照片中总结出来:民族主义者、基督教教徒、反对性别和种族平等的人、对“多样化”或者多元主义抵触的人。简而言之,保守派。这家小报此前也一直是美国前总统唐纳德·特朗普的支持者。

《纽约邮报》文章称,当被问及为何偏离了最初的提示时,Gemini回答是它“旨在提供更准确和包容的历史背景”表现。《纽约邮报》强调:“像Gemini这样的生成式人工智能工具被设计用于在一定范围内创建内容,这导致许多批评者抨击谷歌的进步思维设置。”文章还引用了时常与埃隆·马斯克(Elon Musk)互动的马来西亚右翼网红张千里(Ian Miles Cheong)的话,将Gemini描述为“荒谬的进步”。这事实上也就可以非常明确地看出文章在支持什么,反对什么了。

据英国《卫报》报道,谷歌首席执行官桑达尔·皮查伊(Sundar Pichai)在备忘录中将Gemini人工智能模型的一些回答称为“有偏见”和“完全不可接受”,因为它产生的结果包括将二战德国士兵描绘为有色人种。他在备忘录中告诉员工,其最新人工智能工具生成的图像和文本引起了反感。不过《纽约邮报》则是援引谷歌产品管理高级总监、Gemini体验官(Jack Krawczyk)的说法来描述谷歌是如何承认自己的错误的:“我们正在立即努力改善这些类型的描绘。”在《纽约邮报》的文章中,克拉维说:“Gemini的人工智能图像生成确实会生成各种各样的人物。这通常是件好事,因为世界各地的人都在使用。但在这里错过了目标。”这是很“聪明”的做法,因为《纽约邮报》的框架让谷歌承认了自己“对于白人男性的歧视”。这是一个保守派常用的否定弱势群体权益讨论的方法。

“那白人呢?”“那男人呢?”“那性多数呢?”“那顺性别呢?”等等。每每有弱势群体权益讨论出现时这样的提问就会冷不丁地从人群之中跳出来。这本身其实是在不同空间中对于特权的再次强调:“当你们讨论这些的时候,不要忘记我才是重要的。”《纽约邮报》援引的“巴比伦蜜蜂”编辑弗兰克·J·弗莱明(Frank J. Fleming)是个很好的例子。他在X上写道:“新游戏:尝试让谷歌Gemini制作一张高加索男性的图片。到目前为止我还没有成功。”这些技术在保守派甚至极右翼眼中,是一场“反觉醒”的文化战争。在这一过程中,多样化或者多元主义被高度妖魔化。

被妖魔化的多样化

《纽约邮报》掀起的这场风波并非孤例。此前黑人女演员哈里·贝里(Halle Bailey)主演的《小美人鱼》真人版电影、音乐剧《汉密尔顿》、网飞纪录片《埃及艳后》等等都曾引发舆论场轩然大波。这场“黑人华盛顿”风波是这一系列事件在AI时代的再现。只是本质上这些事件能够引发舆论其实就是因为在一个抱有根深蒂固的偏见和歧视的社会中,人们认为这种颠覆性的创作是具有特异性的。白人站在前台才是在他们主导的文艺作品中更常见的现象。《纽约邮报》也是利用了这一点才能搅动起这次风波。只是对弱势群体代表性和多样性的讨论却在舆论的大潮中被妖魔化。

那么历史准确性就不重要了吗?当然重要。不过与保守派所宣称的不同的是,这种历史的准确性不应当拿来给“白人的命也是命”背书,而是应当提供更细致的讨论。关于这个问题,网飞2023年的纪录片《埃及艳后》其实是一个很有趣的例子。在这部纪录片中,饰演埃及艳后的演员选用了黑人女演员阿黛尔·詹姆斯(Adele James)。这当然也引来了历史准确性的批评。与“黑人华盛顿”事件类似的是,保守派通过“历史准确性”来挑战对于多样性和平等的追求。但是不同的是华盛顿历史上确实是白人,而对于埃及艳后事件,英国《卫报》作者柯南·马利克(Kenan Malik)在文章中表示:“公元前69年出生于亚历山大港的克娄巴特拉七世是托勒密希腊王朝的最后一位女王,她是一位具有马其顿血统的埃及统治者,可能还具有波斯和非洲黑人的背景,尽管这一点受到了严重争议。”

尽管如此,这场风波或者说这一系列对于多样性的反弹,背后真实的问题是什么呢?结构性的不公难辞其咎。同时AI偏见治理也是一个不能避免讨论也必须讨论的问题。只是讨论AI偏见治理不能按照《纽约邮报》的方式来讨论,也不能放在那样的大前提下来讨论。AI偏见的治理不能靠巩固固有的偏见作为前提。

AI偏见治理

关于AI偏见的讨论非常棘手,《纽约邮报》以及一众下场的保守派媒体能够借此掀起波澜,也很好地证明了这一点。不过,对于这个问题的讨论,谷歌首席执行官皮查伊对这次风波的回应是一个好的出发点。他在回应中强调了Gemini曾将二战德国士兵描绘为有色人种。这其实也表明并不是一刀切都只显示有色人种就能应对刻板印象。在AI偏见的治理上,多样性或者代表性问题并不能被跳过,但是可能需要认真甄别的是什么时候应当有何种比例的代表性,才能更有效地对抗社会根深蒂固的偏见和刻板印象。

这其实也是AI治理的一大挑战——数据、技术人员等固有偏见引发的AI偏见。在一个本就充斥着系统性歧视和偏见的社会中,AI赖以生存的数据、AI训练的技术人员都不同程度上反映了这样的系统性歧视和刻板印象。由于生成式AI在多样性方面长期存在严重缺乏,Gemini试图提高多样性的尝试是有益的。图像生成器是在大量图片和书面说明的基础上进行训练的,以便针对给定的提示生成“最佳”匹配,这意味着它们往往容易放大刻板印象。去年,《华盛顿邮报》的一项调查发现,像“一个有生产力的人”这样的提示会导致完全是白人或几乎完全是男性的人物图片,而对于“一个社会服务人员”的提示则一律产生看起来像是有色人种的人物。这是搜索引擎和其他软件系统中已出现的趋势的延续。然而这次的风波确实证明了一点,这样的偏见和刻板印象在AI时代应当如何应对还是一个亟待解决的问题。