当地时间12月6日,谷歌官宣了其最新大模型Gemini 1.0。

Gemini 1.0与LLaMA模型相似,也是一套系列模型,其中包含三个版本:

Gemini Ultra——参数量最大,能力最强,适用于高度复杂的任务。

Gemini Pro——可扩展至各种任务的模型。

Gemini Nano——高效的设备端任务模型。

Gemini 1.0主打多模态能力,谷歌将Gemini定义为一款“原生多模态(natively multimodal)”模型。

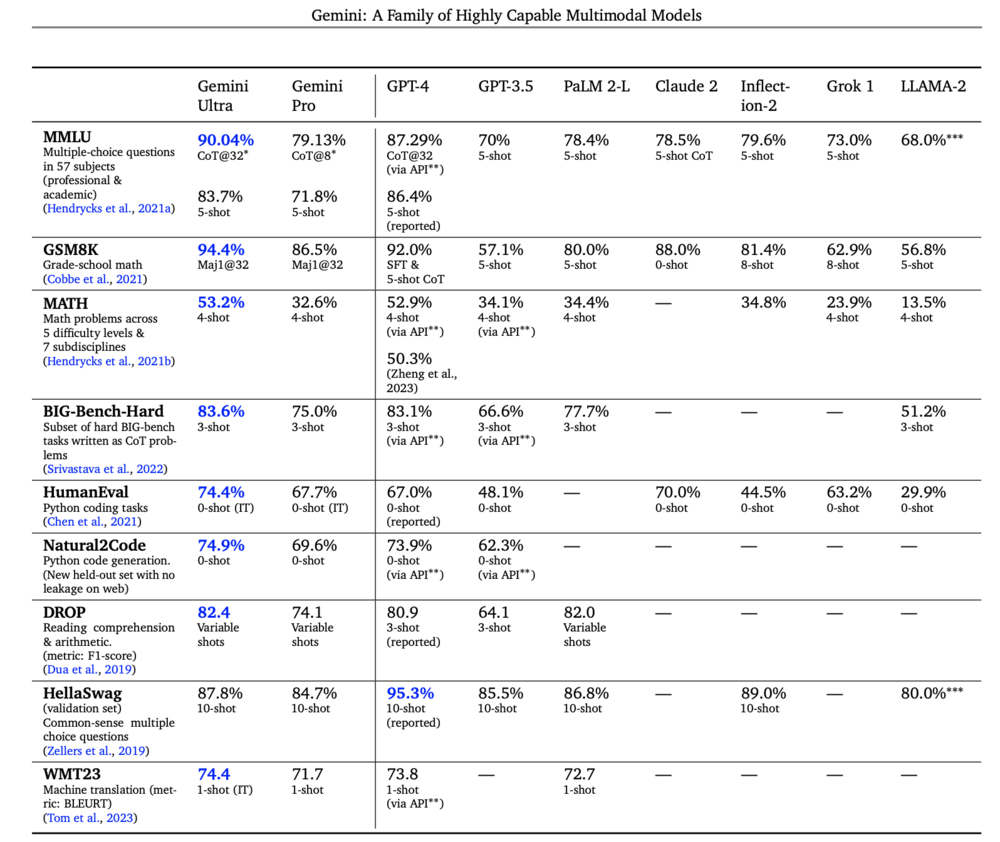

在模型能力方面,谷歌称Gemini Ultra的性能在大型语言模型(LLM)研发中使用的 32 个广泛使用的学术基准中的 30 个超过了当前最先进的结果。

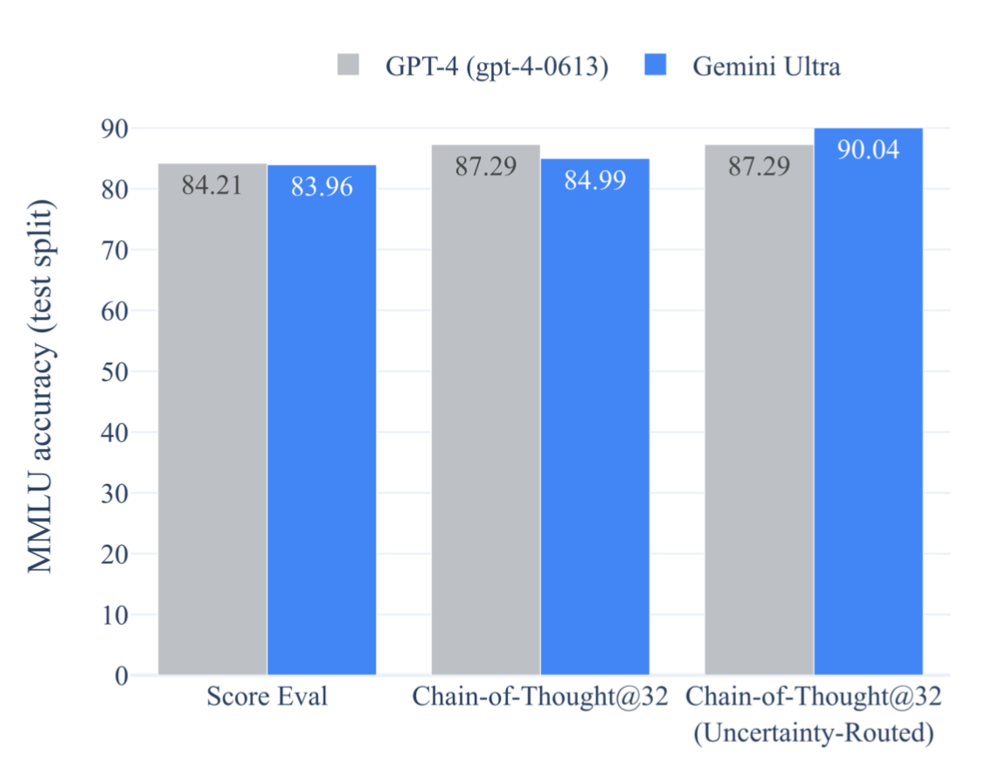

在MMLU(大规模多任务语言理解)测试框架中,Gemini Ultra 的得分高达 90.0%,甚至超越了人类专家。

Gemini被谷歌CEO Sundar Pichai称为“谷歌迄今为止最大、能力最强的AI模型”。

Sundar Pichai在Gemini的官宣博客中写道:

“在许多领先的基准测试中都具有最先进的性能。谷歌的第一个版本 Gemini 1.0 针对不同尺寸进行了优化:Ultra、Pro 和 Nano。这些是 Gemini 时代的第一个模型,也是谷歌今年早些时候成立 Google DeepMind 时的愿景的首次实现。这个模型的新时代代表了谷歌作为一家公司所做出的最大的科学和工程努力之一。我对未来以及双子座将为世界各地的人们带来的机会感到由衷地兴奋。”

目前,谷歌官方称其主打的聊天机器人 Bard已升级至Gemini Pro版本,能力在推理、规划和理解等方面得到显著提升,并继续免费向用户提供服务。谷歌预计明年初推出更为先进的“Bard Advanced”,届时将采用 Gemini Ultra。

在Gemini发布之前,谷歌在生成式AI和LLM方面主推的两款模型PaLM 2和LaMDA,在用户当中收获的评价一直不高,相对于业界领军的GPT-4差距很大。

由此,传闻中谷歌重点研发的Gemini模型一直被寄予厚望。Gemini也是谷歌大脑(Google Brain)和DeepMind合并组建Google DeepMind之后的首个重要产品。

下面我们来看看,Gemini到底牛在哪?

超过人类专家,向强人工智能迈近一步?

“Gemini在MMLU基准测试中超越人类专家。”

虽然,有了AlphaGo的经验,我们并不认为AI在某些领域超越人类是什么新鲜事。但今时不同往日,在ChatGPT带来的AGI、强人工智能“威慑”下,任何被称为超越人类的AI,多多少少都会引人侧目。

那么在这个测试集中超越人类专家,到底有多厉害呢?

大型语言模型(LLM)的主流评测数据集包括:GLUE、SuperGLUE、SQuAD、CommonsenseQA、CoQA、LAMBADA等。通常用于评估模型在语言理解、推理、阅读理解和常识推理等方面的能力。

MMLU(大规模多任务语言理解)是一个结合了数学、物理、历史、法律、医学和伦理学等57个科目的测试集。相比于其他测试集,MMLU的广泛性和深度更强,它通过大量和多样的任务来测试AI模型在理解自然语言方面的能力,特别是在复杂和多变的真实世界场景中的表现。这使得MMLU成为一个极具挑战性的评测框架,可以全面地评估和推动大型语言模型的发展。

GPT-4与Gemini在MMLU测试集的对比

这个框架通常包括数以千计的不同任务,涵盖广泛的主题和挑战。MMLU 的目的是提供一个全面且多样化的方法,测试和评估语言模型在各种复杂和现实世界场景中的表现。其中的测试任务可能包括理解笑话、回答有关世界历史的问题、解释科学现象等众多更接近于人类知识、常识和理解能力的项目。

在MMLU测试中超越人类专家,也可以理解为,在这个测试框架下,Gemini在“各种复杂和现实世界场景中的表现”超越了人类专家。

谷歌在官方博客中称:Gemini利用MMLU基准方法使Gemini能够利用其推理能力在回答难题之前更仔细地思考,从而比仅使用第一印象有显着改进。

除此之外,Gemini Ultra 还在新的MMMU(专家 AGI 的大规模多学科多模式理解和推理)基准测试中取得了59.4%的最先进分数,该基准测试由跨越不同领域、需要深思熟虑的推理的多模态任务组成。

谷歌的测试显示Gemini Ultra 的性能优于之前最先进的模型,无需从图像中提取文本以进行进一步处理的对象字符识别 (OCR) 系统的帮助。这些基准凸显了双子座天生的多模态性,并表明了双子座更复杂推理能力的早期迹象。

Gemini在文本和编码等一系列基准测试中的表现

在某个测试集中超越人类专家,对于AGI或者强人工智能来说虽然还相去甚远,但仍可以说是在这条路上迈出的坚实一步。

原生多模态,比GPT-4更强大?

其实Gemini的LLM性能表现并不是他最大的亮点。Gemini真正值得关注的差异化能力是“原生多模态”。

首先,什么是“Gemini’s native multimodality”(Gemini的原生多模态能力)?

原生多模态能力,指的是Gemini模型固有的能力,可以直接理解和处理多种不同类型的数据,而不需要额外的专门处理或转换。

有人可能会疑惑,那这与GPT-4有何不同?

打个简单的比方:假如GPT-4是一个诗人,他不仅擅长写诗,还会画画,但写诗是他的职业,画画只是他的副业。GPT-4能处理文字(写诗)和图片(画画),但它主要还是以文字处理为强项。

具有“原生多模态能力”的Gemini则是一个诗人、画家“双料人才”,他在写诗和画画方面同样出色,没有哪一方面比另一方面弱。Gemini能够同时处理文字和图片,并且在这两个方面都做得很好,没有主次之分。

GPT-4的多模态能力可能更多地是通过将不同模型的能力集成到一个框架中来实现的,而不是所有功能都在一个统一的模型中原生实现。作为一个大型语言模型,GPT-4的主要优化和训练是围绕语言理解和生成。对于图像处理,虽然它展现了一定的能力,但可能不如那些专门针对图像处理优化的模型。而一个真正的本地多模态模型会在所有模态上都进行平衡和优化。

Gemini的多模态理解能力

原生多模态能力意味着模型能够更自然、高效地处理和融合多种类型的数据,这在实现更复杂的AI应用方面具有重要意义。

当然,这也是更接近人类的理解方式。人类在理解世界时自然地融合了视觉、听觉和语言等多种感官信息。一个具有本地多模态能力的AI模型在处理信息时也采用了类似的综合方式,这更接近于人类的理解和认知方式。

全方位“打败”GPT-4

Gemini不仅是在模型能力和多模态能力方面敢与GPT-4一争高下。在应用方面,也提供了更多选择。

“小模型”

模型系列中的最小尺寸的Gemini Nano模型,被设计为适用于内存受限的端侧设备。它在多种任务上展示了出色的性能,尤其是在多模态和多语言处理方面。Gemini Nano的这些特性使其成为适合在资源受限环境中使用的强大工具。

虽然目前大模型的主流趋势仍是“依云而生”,但在AI未来的商业化版图中,离线、个人化、小型化的端侧模型正在受到越来越多的重视。

过去几个月中,高通、联想等众多巨头都在反复强调自己在端侧生成式AI的战略布局。高通推出的最新一代骁龙芯片对生成式AI提供了强大的支持能力,联想则提出AI PC概念,并强调未来一段时间里将围绕AI对已有的全部产品展开大刀阔斧地改革。

然而,硬件设备厂商非常活跃的同时,AI厂商对端侧的关注却并不怎么高。以百模大战的国内市场为例,目前只有个位数的厂商正式宣布过自己的端侧小模型。其中包括雷军在8月的年度演讲中提到的小米MiLM模型的13亿参数版本,以及通义千问在12月1日开源的Qwen-1.8B模型。

在这方面,相比OpenAI,谷歌更有动力去研究端侧小模型。毕竟谷歌本身具备Pixel手机和Android的双重优势。

训练

谷歌在训练Gemini过程中大量使用了自研的张量处理单元(TPU)v4 和 v5e。

在 TPU 上,Gemini 的运行速度明显快于早期、较小且功能较差的型号。这些定制设计的人工智能加速器一直是谷歌人工智能产品的核心,这些产品为搜索、YouTube、Gmail、谷歌地图、Google Play 和 Android 等数十亿用户提供服务。它们还使世界各地的公司能够经济高效地训练大规模人工智能模型。